El problema es más crítico si se consideran diversas dinámicas, como las realimentaciones.

Iñigo Capellán-Pérez y Carlos de Castro [1]. Revista El Ecologista nº 84.

Un análisis de la metodología del IPCC revela luces pero también sombras. Mientras que el diagnóstico del problema resulta notable, las soluciones planteadas para reducir esas emisiones adolecen de importantes sesgos, y están muy condicionadas por el paradigma científico, tecnológico y social imperante. Pero también se ignoran diferentes dinámicas, interacciones y realimentaciones de los sistemas que pueden ser muy relevantes a la hora de agravar el ya dramático problema del cambio climático.

El Panel Intergubernamental del Cambio Climático o IPCC (por sus siglas en inglés: Intergovernmental Panel on Climate Change) es una organización internacional nacida en 1988, creada a la estela del éxito de la estrategia contra el agujero de la capa de ozono [2]. El panel se encarga de desarrollar evaluaciones científicas sistematizadas sobre la información científica, técnica y socioeconómica actual sobre el riesgo, potenciales consecuencias y posibles soluciones del cambio climático. Sin embargo, es importante aclarar que a pesar de su reputación como cuerpo científico independiente, el IPCC es un proceso híbrido entre comunidad científica y representantes políticos (gubernamentales), como no podría ser de otra manera en un organismo nacido en el seno de Naciones Unidas.

A lo largo de sus más de 25 años de historia, el IPCC ha alcanzado importantes logros, entre los que cabe destacar la intensa colaboración científica internacional (831 expertos y expertas de 85 países en el último informe) con la capacidad de revisión de miles de artículos y realización hasta ahora de 5 grandes informes de síntesis (1990, 1992, 2001, 2007, 2014), así como de otros de temas más específicos [3]. Con el tiempo, este enorme esfuerzo ha logrado divulgar el desafío del cambio climático a la población (principalmente de los países desarrollados) así como colocarlo, aunque en muchos casos solo de forma nominal, en las agendas de la mayoría de países del mundo; siendo su reputación oficial internacional refrendada por la obtención del Nobel de la Paz en 2007.

Sus informes están divididos en 3 áreas principales: la ciencia física del cambio climático (GT1), impactos, adaptación y vulnerabilidad (GT2) y mitigación (GT3). Sin embargo, una radiografía de la metodología del IPCC revela luces pero también sombras. Mientras que los capítulos dedicados al diagnóstico del problema son notables (principalmente GT1; por ejemplo estimando las emisiones acumuladas máximas para evitar un calentamiento “peligroso”), las soluciones planteadas para reducir esas emisiones adolecen de importantes sesgos (principalmente GT3). No en vano, cualquier análisis de propuesta de escenarios futuros es de facto una propuesta con un fuerte componente político por un lado, y que está, por otro, condicionado por el paradigma científico (y también social, como argumentaremos) en que se engloba.

La metodología del IPCC, un reflejo de su época

Como organismo oficial, los escenarios explorados por el IPCC son un esfuerzo (¿inconsciente?) de trazar una línea continuista en lo sustantivo con el business-as-usual (extrapolación de tendencias pasadas) actual. Por ejemplo, a pesar de su diversidad, los escenarios socioeconómicos propuestos proyectan que, hacia 2100, la renta per cápita media global crecerá entre 2 y 14 veces (incluyendo en todos ellos una reducción de las desigualdades), mientras que los escenarios de emisiones sin políticas climáticas prevén incrementos de temperatura para el final del siglo superiores a los 3,5 ºC (recordar que se suele tomar el nivel de 1,5-2 ºC como límite seguro). Esta incoherencia, que el cambio climático no sea a la postre un problema para el progreso desde el punto de vista convencional, o que se interpreten las políticas climáticas como un coste [4], pone de manifiesto fallos importantes en la lógica metodológica con importantes secuelas en la comunicación efectiva del problema.

Puesto que todo modelo [5] es una simplificación de la realidad, repasaremos brevemente a continuación aquellas hipótesis que se manejan habitualmente y que son las responsables de alcanzar estos sorprendentes resultados.

1. Abundancia de recursos y predilección por las soluciones tecnológicas

No se consideran limitaciones de recursos energéticos no renovables (los materiales ni son mencionados) a largo plazo. Así, en la práctica, se asume que, de no aplicarse políticas que restrinjan su uso, su extracción seguirá aumentando a lo largo del siglo XXI. Esto sin discutir la incertidumbre ni valorar las crecientes evidencias que sugieren el declive de origen geológico en la extracción de combustibles fósiles en las próximas décadas [6]. El caso del petróleo es paradigmático, ya se sabe con certeza que el pico de producción del petróleo convencional se alcanzó a mediados del 2000. El mecanismo por el cual automáticamente se asume que la tasa conjunta de descubrimientos futuros y sustitución por fuentes alternativas siempre será mayor que la tasa de declive es la creencia en una mejora tecnológica infalible (vía mejoras de eficiencia, nuevas tecnologías o fuentes de energía).

Por otro lado, se asume que en aquellos escenarios de fuerte reducción de emisiones, las nuevas energías renovables (principalmente biomasa, solar y eólica) serán capaces, técnicamente, de rellenar el hueco dejado por las fósiles. De nuevo, se pasa de puntillas por los obstáculos que se interponen: baja densidad energética que redunda en relativamente bajos potenciales biofísico-sostenibles, escalabilidad, intermitencia, etc. El ejemplo de la biomasa es paradigmático, simulándose tecnologías (como la biomasa de segunda generación en combinación con el almacenamiento y captura de carbono –esta última también aplicada a las fósiles–, que aún no están maduras ni se sabe si lo estarán algún día. Por no hablar de otras divagaciones como la geoingeniería, que algunos gobiernos presionan reiterativamente para incluir en los informes [7].

El acento se pone así en las políticas de oferta por su relación con las innovaciones tecnológicas, mientras que las políticas de demanda (por ejemplo cambios de estilos de vida, dietas, etc.), aunque se reconoce su importancia, en la práctica rara vez son modeladas.

2. Linealidad y modelos de equilibrio

Los modelos empleados son modelos principalmente lineales, es decir con pocas realimentaciones (feedbacks) entre la biosfera y el subsistema humano. El sistema socioeconómico genera unas emisiones que se traducen en incrementos de temperatura. Sin embargo, no se modelan los impactos derivados de ese incremento de temperatura sobre el resto de variables del sistema (por ejemplo: productividades agrícolas, pérdida de biodiversidad, ecosistemas, escasez de agua, migración de población, etc. y el efecto de todos ellas de nuevo sobre el sistema socioeconómico), lo que lleva a los disparatados resultados comentados más arriba. Existen otras realimentaciones que no se tienen en cuenta, y es fácil imaginar multitud, como por ejemplo: los efectos del declive en la calidad de los recursos minerales a medida que decrece su mena [8], la conexión crisis energética-economía, la relación entre desigualdad y estabilidad social, etc. (ver Figura 1 y 2).

Figura 1: Esquema lineal típico empleado en los Modelos de Evaluación Integrada generalmente usados por el IPCC.

Figura 2: Típico esquema rico en realimentaciones de los Modelos de Dinámica de Sistemas; más próximos a una realidad que es compleja:

a) la crisis energética causa crisis económica;

b) el cambio climático necesita adaptación que requiere energía;

c) los impactos del cambio climático causan crisis económica;

d) la economía genera impactos sobre la biodiversidad y esta sobre la economía;

e) el cambio climático genera pérdida de biodiversidad y esta reduce su capacidad de regular el clima.

Si bien es cierto que la integración de las realimentaciones es una tarea ardua y compleja, ignorarlas sistemáticamente lleva a resultados totalmente alejados de la realidad. La falta de realimentación es característica, de nuevo, de una visión típicamente economicista, de “funciones de equilibrio estático” en vez de algo más físico y realista (dinámico) que trate de caracterizar al sistema. De este modo, las irreversibilidades no son tampoco tenidas en cuenta (por ejemplo, los temidos “puntos de no retorno”).

3. Reduccionismo científico: mirando los árboles en vez de al bosque

El reduccionismo, entendido como la hipótesis de que la suma de las partes es igual al todo, es predominante en los modelos. Aunque tiene su campo de validez para aplicaciones específicas, no lo es sin embargo para los sistemas biofísicos y socioeconómicos caracterizados por comportamientos no lineales y realimentaciones. Así, aunque en el discurso se admiten las interacciones con otras dimensiones de la crisis ecológica de la biosfera, al no integrarse en los modelos se pierde completamente el sentido cualitativo de los escenarios futuros.

De esta manera, el método lento de revisión de la literatura (consenso científico), la confusión de la carga de la prueba (una ciencia anti-precavida [9]), y la no consideración de realimentaciones, inducen a la obtención de tendencias conservadoras/lineales, que a menudo son desmentidas por los propios hechos al publicarse los informes; en efecto, es la función exponencial la característica de procesos realimentados positivamente. Así, sistemáticamente, las previsiones de subida del nivel del mar se incrementan en cada informe (a igualdad de emisiones) y sistemáticamente el deshielo del polo norte se prevé que ocurrirá antes en cada informe (modelos del GT1). No olvidemos que ambos fenómenos realimentan a su vez al propio sistema climático.

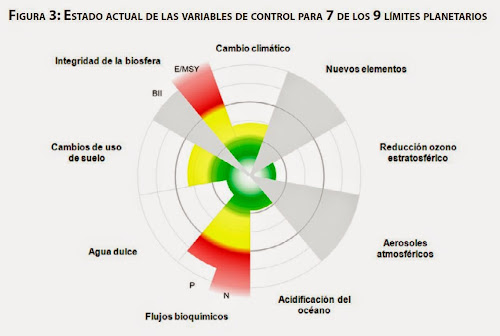

Por otro lado, recientemente se publicó una actualización de la evaluación de los “Límites Planetarios” (ver Figura 3), que puso de manifiesto que se han superado los umbrales de seguridad en 3 variables críticas además del cambio climático: pérdida de biodiversidad y alteración de los ciclos de nitrógeno y fósforo. De forma similar, en 2005 se evaluó que la mayoría de ecosistemas del planeta están en serio declive [10]. Así, el acento no se debería situar tanto en la evaluación por separado de cada límite, sino en las interacciones entre las variables (como en la Figura 2), puesto que la superación de un único umbral durante un cierto tiempo tendría la capacidad de provocar realimentaciones en los subsistemas de la biosfera que podrían incluso inducir cambios de estado permanentes en esta [11]. Además, como sabemos por experiencia, los umbrales ( tipping points. Ver figura 4) se pueden superar sin ser perceptibles para quienes observamos. Inercias y retrasos que, de nuevo, no son modelables en el paradigma del equilibrio estático.

Figura 3: Estado actual de las variables de control para 7 de los 9 límites planetarios. Verde: zona segura; amarillo: riesgo creciente; y rojo: zona de alto riesgo. Fuente: [12]

Figura 4: “Tipping point”. Fuente: [13]

Propuesta

Detrás de estas hipótesis se encuentra un cóctel de mitos culturales profundamente arraigados, junto con la predominancia de la economía convencional (neoclásica, ortodoxa) como “instrumento científico” para el asesoramiento político. En su lugar, pensamos que la ciencia que necesitaríamos requeriría de un cambio metodológico cualitativo caracterizado por el enfoque holista y basado en el principio de precaución, que permitiera acelerar la toma de decisiones eficaces. Su aplicación llevaría, con seguridad, a objetivos de transformación social más perentorios y ambiciosos que las habituales soluciones que confían en la innovación tecnológica.

Así, sería necesario reconocer (y modelar en consecuencia) que en realidad el cambio climático es una componente más de las crisis medioambientales y energéticas. Por otro lado, la aplicación de la ciencia que necesitaríamos requeriría un cambio de paradigma en el modo de hacer ciencia (que por otro lado, vemos que ya está en camino, aunque ¿llegará a tiempo?), así como que el sistema socioeconómico actual adoptase una actitud de cooperación global y de anticipación al medio-largo plazo.

Notas y referencias ![]() Brysse, K.,et al., 2013. Climate change prediction: Erring on the side of least drama? Glob. Environ. Change 23, 327–337. doi:10.1016/j.gloenvcha.2012.10.008

Brysse, K.,et al., 2013. Climate change prediction: Erring on the side of least drama? Glob. Environ. Change 23, 327–337. doi:10.1016/j.gloenvcha.2012.10.008 ![]() IPCC, 2014. Climate Change 2014: Mitigation of Climate Change. Fifth Assess. Rep. Intergov. Panel Clim. Change.

IPCC, 2014. Climate Change 2014: Mitigation of Climate Change. Fifth Assess. Rep. Intergov. Panel Clim. Change. ![]() Mohr, S.H. et al., 2015. Projection of world fossil fuels by country. Fuel 141, 120–135. doi:10.1016/j.fuel.2014.10.030

Mohr, S.H. et al., 2015. Projection of world fossil fuels by country. Fuel 141, 120–135. doi:10.1016/j.fuel.2014.10.030

[1] Grupo de Energía, Economía y Dinámica de Sistemas de la Universidad de Valladolid

[2] Destacar, sin embargo, las diferencias en la magnitud de ambos problemas: mientras que el agujero de la capa de ozono es provocado por unos compuestos químicos empleados en algunas aplicaciones concretas, las emisiones de efecto invernadero proceden de nuestro sistema energético y alimentario global.

[4] El hecho de considerar que las inversiones para evitar una catástrofe climática sean consideradas como un coste es otro absurdo metodológico. El artificio matemático se alcanza puesto que no se valoran los costes de la no-acción.

[5] Nos referimos aquí principalmente a los llamados modelos climáticos de análisis integrado (Climate Integrated Assessment Models) que son los utilizados por el GT3.

[6] http://www.eldiario.es/ultima-llamada/crisis_energetica-peak_oil-transicion_energetica_6_345125495.html

[9] ¿Se trata de demostrar con el 90% de probabilidad que determinado impacto catastrófico puede ocurrir, o bien, tomando el principio de precaución, que nos bastaría un 10%, por ejemplo, de probabilidad para tener en cuenta ese impacto potencial?

[10] MEA, 2005. Millennium Ecosystem Assessment. Ecosystems and Human Well-being: Scenarios, Global Assessment Reports. Island Press.

[11] Barnosky, et al., 2012. Approaching a state shift in Earth/'s biosphere. Nature 486, 52–58. doi:10.1038/nature11018

En palabras de Ferrán Puig Villar: “Un problema inherente a los sistemas es que la superación del umbral de estabilidad (a menudo irreversible, o reversible sólo con histéresis) no tiene por qué presentar señal perceptible alguna. Dos ejemplos. El Titanic ya estaba técnicamente hundido algo antes de que nadie viera el iceberg e intentara, infructuosamente, bordearlo. Dada su posición y velocidad, su masa, su capacidad máxima de frenado, su radio máximo de giro, la resistencia mecánica de los laterales, la configuración interna del buque, etc., hubo un momento en que ya era imposible evitar el hundimiento, mientras pasaje y tripulación seguían de fiesta. Ése es el tipping point auténtico, el punto a partir del cual la vida propia del sistema convierte en inútil la mejor estrategia de los gestores más lúcidos. El sistema había dejado de ser controlable antes de avistar el iceberg, por lo menos en aras de la finalidad mínima deseada, como era mantenerlo a flote”. http://ustednoselocree.com/2014/12/27/hasta-que-punto-es-inminente-el-colapso-de-la-civilizacion-actual-3/

[12] Steffen, W. et al, 2015. Planetary boundaries: Guiding human development on a changing planet. Science 1259855. doi:10.1126/science.1259855